Googleアシスタントもさらに進化

5分でわかる、Google “次の一手”。「Google I/O 2018」の注目ポイントを解説

■「Android P」と「Google Lens」

Google I/Oもうひとつの目玉は、Android OSの次期バージョン「Android P」だ。こちらも「AI機能の強化」を前面に打ち出し、ユーザの操作を分析してアプリの動作に反映することで、スマートフォンの基本システムとしての底上げを計っている。

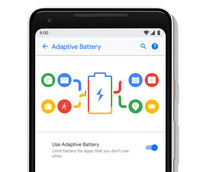

そのひとつが「Adaptive Battery」だ。Googleが2014年に買収した英DeepMindとの共同開発による機能で、よく使うアプリには優先して電力供給を行い、利用頻度の低いアプリには電力供給を抑えることで、消費電力低減を図る。

Adaptive Batteryではまた、画面輝度の自動調整にも機械学習を活用し、ユーザーが手動で輝度調整したときの周囲の明るさなどを反映させることで、「Adaptive Brightness」というより賢い機能へと進化させた。

オーディオ系の目立った新機能は見当たらなかったものの、ユーザーの行動を学習してアプリ利用に生かす「App Actions」は役立ちそう。基調講演では、ヘッドホン端子を端末に挿入するとSpotifyが自のプレイリストを表示する機能が紹介されていたが、これはアプリをApp Actionsに対応させれば良いだけのこと。おそらく、Android Pのリリース後にはこのしくみを利用した音楽再生アプリが続々公開されることだろう。

Google I/O 2017で登場し、その後Pixel端末でのみ利用可能となっていた「Google Lens」のアップデート情報も大きなトピックだ。Google LensはGoogleのAI技術を生かした「ビジュアル検索エンジン」で、スマートフォンカメラを向けたものをスキャンして何が映っているかを調べることができる。

基調講演では、服を着たマネキンにカメラを向けると、シャツやバッグの価格を表示してそのままオンラインショッピングへ進むという事例を紹介していた。

またGoogleマップにも、Google Lensの技術を利用したARナビゲーション機能が搭載されており、基調講演ではカメラの先にある店舗に紹介文を表示するデモを行っていた(「セカイカメラ」と少し似ている)。

だいぶ駆け足でGoogle I/O 2018の発表内容を紹介したが、入力する文章を自動補完してくれる「Gmail」、モノクロ写真をカラー化する「Googleフォト」など、話題になりそうな新機能/アプリはまだまだある。

Android OS以外のプラットフォームで動作するアプリも含まれることから、いつリリースされるのか、どの端末で動くのかを中心に情報をフォローしてほしい。