【連載】佐野正弘のITインサイト 第13回

KDDIの大規模通信障害、解決まで3日近くもかかったのはなぜか

7月2日からおよそ3日間にわたって続いた、KDDIのモバイル通信の大規模通信障害は、既に多くの報道で取り上げられていることからご存知の人も多いことだろう。影響は「au」「UQ mobile」「povo」といったKDDIのモバイル通信サービス利用者だけにとどまらず、より広範囲に及んだことで、問題が一層大きくなったことは間違いない。

オプテージの「mineo」などKDDI回線を借りてサービスしているMVNOや、KDDI回線へのローミングで一部エリアを補っている楽天モバイルなどがその代表例だが、KDDIの通信回線はスマートフォン向けだけでなく、いわゆる「IoT」向けの通信にも利用されている。そのため、IoT向け通信を活用していた銀行のATMや気象観測所など、携帯電話とはあまり関係がなさそうなサービスにも影響が出たのだ。

執筆時点(2022年7月4日)ではまだ障害の全容が明らかにはなっていないが、KDDIでは最大で全国の3,915万回線に影響が及んだ可能性があるとしている。それが3日も続いたことで、社会的にも多くの問題が生じたというのは、報道、あるいは自身や身近な人の経験によって実感した人も多いのではないだろうか。

そこで気になるのはやはり、「なぜKDDIのネットワークに、それだけ長きにわたる大規模な障害が起きたのか」ということだろう。執筆時点では原因究明が進んでいない部分も多いのだが、KDDIから7月3日と4日の2回にわたり、一連の通信障害に関する説明会が実施されており、ある程度の経緯は明らかにされている。そこで改めて、なぜこれだけの大規模障害が発生し、復旧まで3日近い時間を要したのを、改めて確認してみたい。

まず、障害が発生したのは2022年7月2日の深夜1時35分。KDDIの通信拠点の1つ「多摩ネットワークセンター」で、メンテナンス作業としてモバイル通信のコアネットワークの中にあるルーターを、新しいものに交換するメンテナンス作業を実施した際に発生した。ルーターを新しいものに変える際に、4Gのネットワークで音声通話をする「VoLTE」の通信トラフィックルートを変える作業を実施したのだが、その際一部の音声通話が不通となり、およそ15分間音声通話ができない状態に陥ったのである。

そこでKDDIはトラフィックのルートを元に戻す作業をしたのだが、そこでVoLTEによる音声通話に関する処理を担う「VoLTE交換機」にアクセスが集中。通信がしづらくなる「輻輳」という状態に陥ってしまったのだ。

この時間は深夜なので通話をする人が多いとは言えない時間帯なのだが、にもかかわらずアクセスが集中したのには、VoLTEの仕様が影響している。VoLTEに対応した端末では50分に1度ネットワークに接続する仕組みで、音声通話ができなかった15分の間に貯まっていた多数のVoLTE対応端末からのアクセスが集中し、輻輳を招いてしまったというわけだ。

さらにこの輻輳が「加入者データベース」という別の機器の輻輳を呼ぶこととなる。加入者データベースは携帯電話が通信する際、契約者の情報や現在の位置などを登録する、ある意味モバイル通信の要というべき存在だ。

そして端末からネットワークに接続すると、加入者データベースにある端末の情報をVoLTE交換機に書き込むようになっているのだが、今回の場合VoLTE交換機が輻輳でダウンしてしまったことで、輻輳が加入者データベースにも波及。データを書き込めなくなり、加入者データベースとVoLTE交換機のデータに不整合が生じてしまったのだ。

もちろんKDDIとしても、そうしたトラブルの発生に備えて事前に様々な対処法を揃え、シミュレーションも実施していたという。だが輻輳が想定を超えるスピードで発生したため、事前の備えが機能しなかったことが障害の大規模化を招いたようだ。

そこでKDDIは、同日の午前3時より障害への対策を開始している。まずは輻輳が起きているVoLTE交換機の負荷を低減するため、無線通信の50%の流量制限、要はユーザーからのアクセスを50%制限する措置を講じ、さらに加入者データベースの負荷低減も図った。その上で、同日の17時31分から加入者データベースとVoLTE交換機のデータ不整合を修正し、パケット交換機をリセットすることで対処を図っている。

パケット交換機はネットワークの要でもあり、リセット中に端末からの接続要求が殺到すればさらなる輻輳を招きかねない。それだけにこの機器のリセットは「非常に危険な行為」であると、同社の取締役執行役員専務 技術統括本部長である吉村和幸氏は話していた。輻輳を起こさないよう時間をかけて順次リセットをかけていったと吉村氏は話すが、対処が困難を極めたことは想像に難くない。

ちなみに同日は沖縄や奄美大島に台風が迫っており、総務省からそれら地域での復旧を急ぐよう要請もあったようだ。それゆえKDDIではパケット交換機を東日本と西日本とで切り離して処理し、台風が迫る地域を含む西日本側の復旧を急いだとのことだ。

一連の施策によって西日本側が同日11時、東日本側が同日17時30分に復旧したというが、その後も流量制限は継続、特に音声通話が利用しづらい状況が続いていた。その理由は一連の策を講じてもなお、VoLTE交換機や加入者データベースの負荷が十分に下がらなかったためで、翌7月4日まで検証を進めたところ、一部のVoLTE交換機に原因があることを突き止めたという。

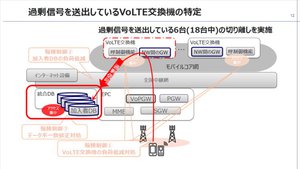

具体的には、18台あるVoLTE交換機のうち6台が、加入者データベースに不要な信号を過剰に送っていたそうで、これは一連の障害によって発生したものだと吉村氏は説明している。そこでKDDIは6台のVoLTE交換機をネットワークから切り離すことで、負荷低減を図ったという。VoLTE交換機の台数自体は減ってしまうが、元々十分な処理能力を持っていたことから、残りの12台でも処理が可能とのことだ。

これでようやく障害発生前と同水準の能力を回復したことから、50%の流量制限を徐々に緩和。同日14時51分には流量制限を完全解除するに至っている。ただ、これだけ大規模な障害に至っただけに、再び何らかの問題が発生しないようKDDIとしても慎重を期したいようで、4日時点ではネットワークの監視を続けている状況。完全復旧を宣言するのは、監視の末に問題がないことが確認された後の5日夕方頃になるとのことだ。

ただし、ここまでの説明は、通信障害の対応をし終えた直後の情報に基づくものであり、原因究明はあくまでこれからという段階だ。それゆえなぜルーターの交換で音声通話が止まったのか、対処が間に合わないほどのスピードで輻輳が起きたのはなぜか……など、現時点では不明な点も多い。通信障害の全体像が見通せるのはもう少し先のことになるだろう。

2018年のソフトバンク、2021年のNTTドコモ、そして今回のKDDIと、ここ最近相次いで通信障害が起き、しかも年々その規模が大きくなっている。3Gから4G、5Gと進むにつれてネットワークの仕組みが複雑になることで、障害の影響の広がり方や、その対処の仕方が以前とは大きく変わっている印象を受ける。例えば今回の通信障害に大きく影響したVoLTEは、4Gのデータ通信で音声通話を実現する仕組みで、音声とデータ通信が明確に分かれていた3Gの時代には存在しなかったものでもある。

それに加えて、今回の事例を見ても分かる通り、モバイル通信は今や人同士のコミュニケーションにとどまらない、幅広い活用がなされており重要性が年々高まっている状況だ。

KDDIには今回の反省を生かし、大規模障害が発生しないためのネットワーク強靭化が求められるのは確かだが、どの会社も未来永劫障害をゼロにすることはできないだろう。

それゆえ利用する側にも、通信障害が起き得ることを前提として、複数回線を契約しておくなど、“備え”が必要な時期に来ているのではないかと筆者は感じている。

オプテージの「mineo」などKDDI回線を借りてサービスしているMVNOや、KDDI回線へのローミングで一部エリアを補っている楽天モバイルなどがその代表例だが、KDDIの通信回線はスマートフォン向けだけでなく、いわゆる「IoT」向けの通信にも利用されている。そのため、IoT向け通信を活用していた銀行のATMや気象観測所など、携帯電話とはあまり関係がなさそうなサービスにも影響が出たのだ。

執筆時点(2022年7月4日)ではまだ障害の全容が明らかにはなっていないが、KDDIでは最大で全国の3,915万回線に影響が及んだ可能性があるとしている。それが3日も続いたことで、社会的にも多くの問題が生じたというのは、報道、あるいは自身や身近な人の経験によって実感した人も多いのではないだろうか。

そこで気になるのはやはり、「なぜKDDIのネットワークに、それだけ長きにわたる大規模な障害が起きたのか」ということだろう。執筆時点では原因究明が進んでいない部分も多いのだが、KDDIから7月3日と4日の2回にわたり、一連の通信障害に関する説明会が実施されており、ある程度の経緯は明らかにされている。そこで改めて、なぜこれだけの大規模障害が発生し、復旧まで3日近い時間を要したのを、改めて確認してみたい。

まず、障害が発生したのは2022年7月2日の深夜1時35分。KDDIの通信拠点の1つ「多摩ネットワークセンター」で、メンテナンス作業としてモバイル通信のコアネットワークの中にあるルーターを、新しいものに交換するメンテナンス作業を実施した際に発生した。ルーターを新しいものに変える際に、4Gのネットワークで音声通話をする「VoLTE」の通信トラフィックルートを変える作業を実施したのだが、その際一部の音声通話が不通となり、およそ15分間音声通話ができない状態に陥ったのである。

そこでKDDIはトラフィックのルートを元に戻す作業をしたのだが、そこでVoLTEによる音声通話に関する処理を担う「VoLTE交換機」にアクセスが集中。通信がしづらくなる「輻輳」という状態に陥ってしまったのだ。

この時間は深夜なので通話をする人が多いとは言えない時間帯なのだが、にもかかわらずアクセスが集中したのには、VoLTEの仕様が影響している。VoLTEに対応した端末では50分に1度ネットワークに接続する仕組みで、音声通話ができなかった15分の間に貯まっていた多数のVoLTE対応端末からのアクセスが集中し、輻輳を招いてしまったというわけだ。

さらにこの輻輳が「加入者データベース」という別の機器の輻輳を呼ぶこととなる。加入者データベースは携帯電話が通信する際、契約者の情報や現在の位置などを登録する、ある意味モバイル通信の要というべき存在だ。

そして端末からネットワークに接続すると、加入者データベースにある端末の情報をVoLTE交換機に書き込むようになっているのだが、今回の場合VoLTE交換機が輻輳でダウンしてしまったことで、輻輳が加入者データベースにも波及。データを書き込めなくなり、加入者データベースとVoLTE交換機のデータに不整合が生じてしまったのだ。

もちろんKDDIとしても、そうしたトラブルの発生に備えて事前に様々な対処法を揃え、シミュレーションも実施していたという。だが輻輳が想定を超えるスピードで発生したため、事前の備えが機能しなかったことが障害の大規模化を招いたようだ。

そこでKDDIは、同日の午前3時より障害への対策を開始している。まずは輻輳が起きているVoLTE交換機の負荷を低減するため、無線通信の50%の流量制限、要はユーザーからのアクセスを50%制限する措置を講じ、さらに加入者データベースの負荷低減も図った。その上で、同日の17時31分から加入者データベースとVoLTE交換機のデータ不整合を修正し、パケット交換機をリセットすることで対処を図っている。

パケット交換機はネットワークの要でもあり、リセット中に端末からの接続要求が殺到すればさらなる輻輳を招きかねない。それだけにこの機器のリセットは「非常に危険な行為」であると、同社の取締役執行役員専務 技術統括本部長である吉村和幸氏は話していた。輻輳を起こさないよう時間をかけて順次リセットをかけていったと吉村氏は話すが、対処が困難を極めたことは想像に難くない。

ちなみに同日は沖縄や奄美大島に台風が迫っており、総務省からそれら地域での復旧を急ぐよう要請もあったようだ。それゆえKDDIではパケット交換機を東日本と西日本とで切り離して処理し、台風が迫る地域を含む西日本側の復旧を急いだとのことだ。

一連の施策によって西日本側が同日11時、東日本側が同日17時30分に復旧したというが、その後も流量制限は継続、特に音声通話が利用しづらい状況が続いていた。その理由は一連の策を講じてもなお、VoLTE交換機や加入者データベースの負荷が十分に下がらなかったためで、翌7月4日まで検証を進めたところ、一部のVoLTE交換機に原因があることを突き止めたという。

具体的には、18台あるVoLTE交換機のうち6台が、加入者データベースに不要な信号を過剰に送っていたそうで、これは一連の障害によって発生したものだと吉村氏は説明している。そこでKDDIは6台のVoLTE交換機をネットワークから切り離すことで、負荷低減を図ったという。VoLTE交換機の台数自体は減ってしまうが、元々十分な処理能力を持っていたことから、残りの12台でも処理が可能とのことだ。

これでようやく障害発生前と同水準の能力を回復したことから、50%の流量制限を徐々に緩和。同日14時51分には流量制限を完全解除するに至っている。ただ、これだけ大規模な障害に至っただけに、再び何らかの問題が発生しないようKDDIとしても慎重を期したいようで、4日時点ではネットワークの監視を続けている状況。完全復旧を宣言するのは、監視の末に問題がないことが確認された後の5日夕方頃になるとのことだ。

ただし、ここまでの説明は、通信障害の対応をし終えた直後の情報に基づくものであり、原因究明はあくまでこれからという段階だ。それゆえなぜルーターの交換で音声通話が止まったのか、対処が間に合わないほどのスピードで輻輳が起きたのはなぜか……など、現時点では不明な点も多い。通信障害の全体像が見通せるのはもう少し先のことになるだろう。

2018年のソフトバンク、2021年のNTTドコモ、そして今回のKDDIと、ここ最近相次いで通信障害が起き、しかも年々その規模が大きくなっている。3Gから4G、5Gと進むにつれてネットワークの仕組みが複雑になることで、障害の影響の広がり方や、その対処の仕方が以前とは大きく変わっている印象を受ける。例えば今回の通信障害に大きく影響したVoLTEは、4Gのデータ通信で音声通話を実現する仕組みで、音声とデータ通信が明確に分かれていた3Gの時代には存在しなかったものでもある。

それに加えて、今回の事例を見ても分かる通り、モバイル通信は今や人同士のコミュニケーションにとどまらない、幅広い活用がなされており重要性が年々高まっている状況だ。

KDDIには今回の反省を生かし、大規模障害が発生しないためのネットワーク強靭化が求められるのは確かだが、どの会社も未来永劫障害をゼロにすることはできないだろう。

それゆえ利用する側にも、通信障害が起き得ることを前提として、複数回線を契約しておくなど、“備え”が必要な時期に来ているのではないかと筆者は感じている。