つなぐ/解き放つ/超える

ソニー、「Sony Technology Day」で最新技術を披露。センシング技術やAIを用いたデモを実施

ソニーは本日、メディア関係者向けに同社技術を紹介するイベント「Sony Technology Day」を開催。開発を進める様々な新技術を披露した。

開催に先駆け、同社社長兼CEOの吉田憲一郎氏が登壇。ソニーが経営方針としている『人に近づく』というキーワードに触れ、「クリエイターやユーザーといった人、あるいは人の動機を中心とした」と、展示内容のテーマについて説明した。

また「人は空間と時間で生きる存在であることから、空間と時間の価値創造に取り組むべき」との考えを述べ、ARやVRといった目と耳で捉える音とリアリティの追求、またリアルタイムといった時間軸を組み合わせるなどの取り組みも多いとアピールした。

続いて登壇した専務 R&D担当の勝本 徹氏によると、先述した『人に近づく』というテーマをもとに、今回のイベントでは「つなぐ」「解き放つ」「超える」の3つに要素を分けたという。展示内容の詳細について、これらの要素ごとに紹介していきたい。

■つなぐ

“つなぐ” では、音響や映像に関わるテクノロジーについて紹介。まず『クリエイターの意図する映像を届ける』として、テレビの高画質化技術についての取り組みを解説した。

同社は8Kテレビ「Z9G」を海外で発表しているが、8Kは情報量が多いから画面に近づいて視聴しても問題ないという立場ではなく、「8Kの真の価値はリアリティー」として、「より大きな感動を届けることが可能」であることに価値を置いている。

このリアリティーを実現するために、解像度/フレームレート/輝度範囲/色域/階調の5要素を高いレベルでバランスさせているという。これを実現しているのが、映像エンジン「X1 Ultimate」やディスプレイドライバー、バックライト技術といった、これまで培われてきた厳しい目や技術的ノウハウだ。

デモでは『グランツーリスモ』のデータを8Kでレンダリングした映像と、同社の3板式カメラ「UHC-8300」で撮影したリオのカーニバルの映像を再生した。また “コンテンツは感動の源泉” としており、テレビが先んじて実現した再生環境をクリエイターに提供して、新しいコンテンツを創造してもらうといったサイクルも重要と説明する。

画質関連の展示としては、『クリエイターの意図する映像を届ける』という題名で、「Xperia 1」を用いた取り組みについても紹介した。Xperia 1は映画製作などに使われるマスターモニター「BVM-HX310」などの技術を搭載することで、これら業務用モニターに迫る表現を実現したモデル。

従来の映画製作では現場に設置した1台のモニターを複数人で覗き込んでいたが、同社シネマカメラ「VENICE」に接続できる伝送システムを制作することで、これを無線化。Xperia 1にワイヤレスで伝送して、複数人がそれぞれのデバイスで確認できる。また映像製作フローでは、5Gを活用することで中継機の役割とクラウド化する取り組みも説明された。

サウンドについては、今年のCES2019で発表したオブジェクトベース空間音響技術「360 Reality Audio」を改めてアピールした。この技術は従来のステレオ再生とは異なり、360度からの音にリスナーが包まれるという音楽体験を実現するもの。

デモでは耳の高さに5つ、頭上に5つ、前方の足元に3つのスピーカーを設置してサラウンドを再生。また耳にマイクを装着して測定、音楽をバイノーラル化して再生することで、ヘッドホンでもスピーカーから聴こえるようなサラウンド再生を体験できた。なお今後の展望として、耳の写真を撮影するだけで、マイクで測定せずとも手軽にヘッドホンでのサラウンド再生ができるようにする計画があるという。

■解き放つ

つづいて “解き放つ” では、2Dから3Dへの拡張やリアルとバーチャルの融合といった、VRやARのような新しい感動を生み出す技術をラインナップ。『光を自在に操り、リアルに迫る』という展示では、「リアルタイムレイトレーシング」という技術を用いることで、リアルタイムに写実的な3D映像を生成できることが紹介された。

デモにはGPU(Geforce GTX2080 Ti)を各10枚搭載したサーバー3台を用いて、リアルタイムに空間を生成。1ピクセルあたり72光線軌道、これを4K(約830万)分実施し、1フレームあたり597,196,800通りの計算が行われる。

VRコントローラーを動かすと、ディスプレイに映る映像の視点も変化。鏡面素材やガラス素材などのマテリアルの変更、ボケ感といったレンズのシミュレーションなども行える。ほか、WEBカメラで物体を写すと、ディープラーニングを用いて推測、その素材の質感やテカリ具合を再現するという機能も搭載する。

現在は物体のみだが、最終的には人間をリアルタイムで表現したいとのこと。そしてこれら研究によって得られた技術は、より実写に近い映像のゲームをはじめ、映画のCG製作のクオリティ向上・コスト削減などに役立っていくという。

また『撮影した人物を立体空間に登場させる』という展示では、ディープラーニングにより、グリーンバックなどを用いるクロマキー合成をせずに、人物を抽出できる技術を利用。加えて頭を動かすことで映像内の物体の位置関係が変化する6DoF視点を用いることで、自然なVR体験を目指していた。

VRに関連する技術の展示は多く、このほかにも小型軽量センサーを6ヶ所に装着するだけでモーションキャプチャーが可能な技術をデモ。腕や足首などに装着すれば、こちらもディープラーニングを活用し、関節位置を割り出すことが可能だ。また複数のカメラを用いて空間を撮りこみ再現する「Volumetric Capture」技術では、スマホを使用してARでのダンスシーンを様々な角度から鑑賞できた。

■超える

3つめとなる “超える” では、主にセンシング技術を活かすことで人間の限界を拡張するテクノロジーを提案。いずれも同社がセンサーを自社開発していることを強みとしており、イメージング技術やAI技術を応用している。

センサーの自社開発が大きく役立っている展示が、車の安全装備において、人間の目でも捉えられないような検出精度についてフォーカスしたもの。夜間の歩行者や遠方の障害物、逆光時の物体の認識などは人間の眼のほうがカメラに勝っていた部分であり、逆にカメラにとっては苦手なシーンとして課題だった。

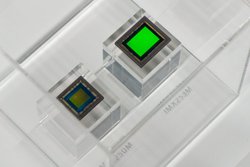

これを同社では新型のCMOSイメージセンサー「IMX490」(540万画素)を開発することで解決。低照度感度を改善することで月明かりでも識別が可能になり、解像度を高めることで160m先といった遠距離でも速度標識の視認が可能に。またダイナミックレンジを改善(120dB)し、90Hz駆動によってLEDフリッカーも抑制することで、逆光でもLED標識をちらつきなく視認できるようになった。

そしてこの技術に、レーダーを組み合わせる「センサーフュージョン技術」を活用することで、雨・霧・逆光といった悪天候下でも物体認識が可能になるとのこと。カメラは逆光・霧が苦手で、レーダーはトンネルや鉄橋といった乱反射でノイズが発生するシーンで苦手だったという。

従来はカメラとレーダーによる物体認識を別々に処理し、それぞれの認識結果を統合していたことから、物体が捉えられていない、ノイズがあるなど誤りを含んだデータとなってしまうことがあった。しかし今回の技術では、それぞれのRAWデータを取得し、融合して最適な処理を実施することで、高精度な認識が実現できる。これは両センサーを自社開発しているから可能とのことだ。

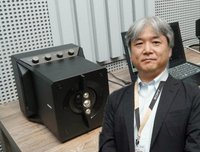

人間の眼を超える技術として「偏光イメージセンサー」も展示された。これは半導体プロセスで偏光子をセンサーに搭載したもので、開発は世界初という。0/45/135/90度といった4方向の偏光子が各画素に配置されており、従来の明るさ(振幅)と色(波長)に加えて、光の方向(偏光)をセンサーのみで捉えることができる。

この偏光が役立つのは、主に検査や検出の分野とのこと。デモでは一例として、車体の塗装につけられた傷、透明な物体の歪みなど通常は人間の眼でみることのできない映像を可視化させていた。

またaiboにも搭載されているビジョンセンサーを発展させ、全方位のリアルタイムセンシングを実現する技術も紹介。センシング向けイメージセンサーをはじめ、プロセッサーやアルゴリズムをそれぞれ進化させることで、低消費電力でありながらも高速高精度なものを目指しているという。

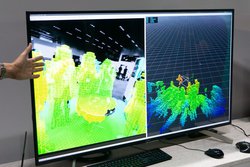

デモではステレオカメラを用いて物体までの距離を検出、物体の情報を3D空間状に地図としてリアルタイムで記録した。この技術をドローンに使うことで、GPSを使用しなくても位置を判断することもできるという。また、システムを市販のモバイルバッテリーで駆動することで、先述した低消費電力もアピールされた。

そのほか、1/10スケールの世界に触れるという技術も印象的だった。デモでは3D表示のモニターを見ながらロボットアームを操作しているのだが、アームの動きと力を制御することで、やわらかさや重さなどを感じながら操作できるとのこと。人間では困難な、0.2mmという大きさの物体に対しても、自在に持ち上げたりしていた。

これを実現する大きな要素は、光ファイバーを用いたセンシング技術。配置した光ファイバーの歪みを検出し、そのデータからどのくらいの力なのか取得する。これを先端に4本、手首の部分に4本搭載することで、様々な方向から加わる力も検出できるという。

本日の展示では、同社のさまざまなテクノロジーを見ることができた。しかしこれらの技術は、数多くあるうちのほんの一握りとのこと。今後も『テクノロジー』をキーワードに開発に力を注ぐと同社は意気を示した。

開催に先駆け、同社社長兼CEOの吉田憲一郎氏が登壇。ソニーが経営方針としている『人に近づく』というキーワードに触れ、「クリエイターやユーザーといった人、あるいは人の動機を中心とした」と、展示内容のテーマについて説明した。

また「人は空間と時間で生きる存在であることから、空間と時間の価値創造に取り組むべき」との考えを述べ、ARやVRといった目と耳で捉える音とリアリティの追求、またリアルタイムといった時間軸を組み合わせるなどの取り組みも多いとアピールした。

続いて登壇した専務 R&D担当の勝本 徹氏によると、先述した『人に近づく』というテーマをもとに、今回のイベントでは「つなぐ」「解き放つ」「超える」の3つに要素を分けたという。展示内容の詳細について、これらの要素ごとに紹介していきたい。

■つなぐ

“つなぐ” では、音響や映像に関わるテクノロジーについて紹介。まず『クリエイターの意図する映像を届ける』として、テレビの高画質化技術についての取り組みを解説した。

同社は8Kテレビ「Z9G」を海外で発表しているが、8Kは情報量が多いから画面に近づいて視聴しても問題ないという立場ではなく、「8Kの真の価値はリアリティー」として、「より大きな感動を届けることが可能」であることに価値を置いている。

このリアリティーを実現するために、解像度/フレームレート/輝度範囲/色域/階調の5要素を高いレベルでバランスさせているという。これを実現しているのが、映像エンジン「X1 Ultimate」やディスプレイドライバー、バックライト技術といった、これまで培われてきた厳しい目や技術的ノウハウだ。

デモでは『グランツーリスモ』のデータを8Kでレンダリングした映像と、同社の3板式カメラ「UHC-8300」で撮影したリオのカーニバルの映像を再生した。また “コンテンツは感動の源泉” としており、テレビが先んじて実現した再生環境をクリエイターに提供して、新しいコンテンツを創造してもらうといったサイクルも重要と説明する。

画質関連の展示としては、『クリエイターの意図する映像を届ける』という題名で、「Xperia 1」を用いた取り組みについても紹介した。Xperia 1は映画製作などに使われるマスターモニター「BVM-HX310」などの技術を搭載することで、これら業務用モニターに迫る表現を実現したモデル。

従来の映画製作では現場に設置した1台のモニターを複数人で覗き込んでいたが、同社シネマカメラ「VENICE」に接続できる伝送システムを制作することで、これを無線化。Xperia 1にワイヤレスで伝送して、複数人がそれぞれのデバイスで確認できる。また映像製作フローでは、5Gを活用することで中継機の役割とクラウド化する取り組みも説明された。

サウンドについては、今年のCES2019で発表したオブジェクトベース空間音響技術「360 Reality Audio」を改めてアピールした。この技術は従来のステレオ再生とは異なり、360度からの音にリスナーが包まれるという音楽体験を実現するもの。

デモでは耳の高さに5つ、頭上に5つ、前方の足元に3つのスピーカーを設置してサラウンドを再生。また耳にマイクを装着して測定、音楽をバイノーラル化して再生することで、ヘッドホンでもスピーカーから聴こえるようなサラウンド再生を体験できた。なお今後の展望として、耳の写真を撮影するだけで、マイクで測定せずとも手軽にヘッドホンでのサラウンド再生ができるようにする計画があるという。

■解き放つ

つづいて “解き放つ” では、2Dから3Dへの拡張やリアルとバーチャルの融合といった、VRやARのような新しい感動を生み出す技術をラインナップ。『光を自在に操り、リアルに迫る』という展示では、「リアルタイムレイトレーシング」という技術を用いることで、リアルタイムに写実的な3D映像を生成できることが紹介された。

デモにはGPU(Geforce GTX2080 Ti)を各10枚搭載したサーバー3台を用いて、リアルタイムに空間を生成。1ピクセルあたり72光線軌道、これを4K(約830万)分実施し、1フレームあたり597,196,800通りの計算が行われる。

VRコントローラーを動かすと、ディスプレイに映る映像の視点も変化。鏡面素材やガラス素材などのマテリアルの変更、ボケ感といったレンズのシミュレーションなども行える。ほか、WEBカメラで物体を写すと、ディープラーニングを用いて推測、その素材の質感やテカリ具合を再現するという機能も搭載する。

現在は物体のみだが、最終的には人間をリアルタイムで表現したいとのこと。そしてこれら研究によって得られた技術は、より実写に近い映像のゲームをはじめ、映画のCG製作のクオリティ向上・コスト削減などに役立っていくという。

また『撮影した人物を立体空間に登場させる』という展示では、ディープラーニングにより、グリーンバックなどを用いるクロマキー合成をせずに、人物を抽出できる技術を利用。加えて頭を動かすことで映像内の物体の位置関係が変化する6DoF視点を用いることで、自然なVR体験を目指していた。

VRに関連する技術の展示は多く、このほかにも小型軽量センサーを6ヶ所に装着するだけでモーションキャプチャーが可能な技術をデモ。腕や足首などに装着すれば、こちらもディープラーニングを活用し、関節位置を割り出すことが可能だ。また複数のカメラを用いて空間を撮りこみ再現する「Volumetric Capture」技術では、スマホを使用してARでのダンスシーンを様々な角度から鑑賞できた。

■超える

3つめとなる “超える” では、主にセンシング技術を活かすことで人間の限界を拡張するテクノロジーを提案。いずれも同社がセンサーを自社開発していることを強みとしており、イメージング技術やAI技術を応用している。

センサーの自社開発が大きく役立っている展示が、車の安全装備において、人間の目でも捉えられないような検出精度についてフォーカスしたもの。夜間の歩行者や遠方の障害物、逆光時の物体の認識などは人間の眼のほうがカメラに勝っていた部分であり、逆にカメラにとっては苦手なシーンとして課題だった。

これを同社では新型のCMOSイメージセンサー「IMX490」(540万画素)を開発することで解決。低照度感度を改善することで月明かりでも識別が可能になり、解像度を高めることで160m先といった遠距離でも速度標識の視認が可能に。またダイナミックレンジを改善(120dB)し、90Hz駆動によってLEDフリッカーも抑制することで、逆光でもLED標識をちらつきなく視認できるようになった。

そしてこの技術に、レーダーを組み合わせる「センサーフュージョン技術」を活用することで、雨・霧・逆光といった悪天候下でも物体認識が可能になるとのこと。カメラは逆光・霧が苦手で、レーダーはトンネルや鉄橋といった乱反射でノイズが発生するシーンで苦手だったという。

従来はカメラとレーダーによる物体認識を別々に処理し、それぞれの認識結果を統合していたことから、物体が捉えられていない、ノイズがあるなど誤りを含んだデータとなってしまうことがあった。しかし今回の技術では、それぞれのRAWデータを取得し、融合して最適な処理を実施することで、高精度な認識が実現できる。これは両センサーを自社開発しているから可能とのことだ。

人間の眼を超える技術として「偏光イメージセンサー」も展示された。これは半導体プロセスで偏光子をセンサーに搭載したもので、開発は世界初という。0/45/135/90度といった4方向の偏光子が各画素に配置されており、従来の明るさ(振幅)と色(波長)に加えて、光の方向(偏光)をセンサーのみで捉えることができる。

この偏光が役立つのは、主に検査や検出の分野とのこと。デモでは一例として、車体の塗装につけられた傷、透明な物体の歪みなど通常は人間の眼でみることのできない映像を可視化させていた。

またaiboにも搭載されているビジョンセンサーを発展させ、全方位のリアルタイムセンシングを実現する技術も紹介。センシング向けイメージセンサーをはじめ、プロセッサーやアルゴリズムをそれぞれ進化させることで、低消費電力でありながらも高速高精度なものを目指しているという。

デモではステレオカメラを用いて物体までの距離を検出、物体の情報を3D空間状に地図としてリアルタイムで記録した。この技術をドローンに使うことで、GPSを使用しなくても位置を判断することもできるという。また、システムを市販のモバイルバッテリーで駆動することで、先述した低消費電力もアピールされた。

そのほか、1/10スケールの世界に触れるという技術も印象的だった。デモでは3D表示のモニターを見ながらロボットアームを操作しているのだが、アームの動きと力を制御することで、やわらかさや重さなどを感じながら操作できるとのこと。人間では困難な、0.2mmという大きさの物体に対しても、自在に持ち上げたりしていた。

これを実現する大きな要素は、光ファイバーを用いたセンシング技術。配置した光ファイバーの歪みを検出し、そのデータからどのくらいの力なのか取得する。これを先端に4本、手首の部分に4本搭載することで、様々な方向から加わる力も検出できるという。

本日の展示では、同社のさまざまなテクノロジーを見ることができた。しかしこれらの技術は、数多くあるうちのほんの一握りとのこと。今後も『テクノロジー』をキーワードに開発に力を注ぐと同社は意気を示した。