マカフィーがレポートを発表

10人に1人が被害に。AIを悪用した音声詐欺が世界で増加、どうすれば身を守れる?

(株)マカフィーは、AI(人工知能)を悪用した音声詐欺が世界で増加中であり、成人の10人に1人が被害に遭遇しているとの調査結果を発表した。

これは、同社が日本を含む世界7か国(日本、米国、英国、ドイツ、フランス、インド、オーストラリア)を対象に実施した、AIを悪用したオンライン音声詐欺の現状に関するレポート「The Artificial Imposter」に基づくもの。

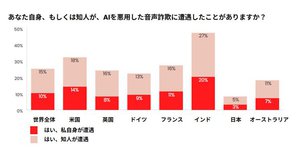

上記7か国の18歳以上の成人7,054人を対象に調査を行ったところ、10%が自身がAI音声詐欺に遭遇、15%が知人が遭遇したとの回答があったという。さらに、被害者の77%が実際に金銭被害にあったと回答している。

なお、日本のオンライン音声詐欺の遭遇率は世界7か国で最も低くなっており、自身が遭遇は3%、知人が遭遇は5%と、世界平均の約3分の1に留まった。

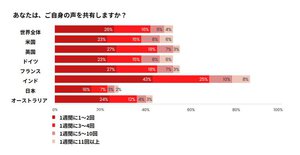

人の声(声紋)は、いまや非常に高精度な個人認識が可能だが、調査対象となった世界の成人の過半数が週に1回以上、全体の10%は週に5回以上、自身の音声データをオンラインで共有している。この声がサイバー犯罪者に狙われて、コピー・悪用される格好の材料となっている。

同社の調べによれば、詐欺師はAI技術を使って声のクローンを作り、困窮を偽ったボイスメールを送ったり、被害者の連絡先に電話をかけていることが明らかになっている。また、クローン音声と本物の識別については、「識別できるかどうかわからない(35%)」または「識別できないと思う(35%)」として、およそ70%の回答者が自信がないと答えており、音声クローニングによる詐欺が勢いを増す要因にもなっているという。

さらに今回の調査では、ディープフェイクや偽情報が増加することで、オンラインで目にする情報に対してより警戒心が高まっているということも判明。成人の実に32%が、以前よりもソーシャルメディアに対する信頼度が下がったと回答した。

なお、日本の音声データのオンライン共有についてもまた世界7か国で最も低く、週1回以上の共有が28%、週に5回以上は5%で、世界平均の半分ほど。オンライン共有をあまり行わないことも、オンライン音声詐欺の遭遇率の低さにつながっているとも考えられる。とはいえ、“音声クローンが3秒で作成できる” という今、日本においても注意が必要と同社は呼びかける。

では、AIを悪用した音声クローニングの詐欺から身を守るにはどのような方法があるのかだが、マカフィーはまず、家族や信頼できる親しい友人との間でのみ通用する「パスワード(合言葉)」の共有を推奨。特に、高齢者や、家族、友人が電話や電子メールで助けを求めてくる際は「相手にパスワード(合言葉)を求めることを習慣づけるようにしましょう」とアドバイスしている。

また、根本的に発信者への疑念を抱くことも大切だとする。知らない発信者からの電話やテキスト、電子メールのみならず、見覚えのある番号からの発信であっても、送金など詐欺に類する行為を求めてくる場合には、「一呼吸置き、電話を切る、相手に直接電話をかけ直すか、情報を確認してから応答する」などを心掛けるように勧めている。

ほか、ソーシャルメディアネットワークに参加している場合、自分のアイデンティティを共有するほど自身のアイデンティティが悪意のある目的でクローン化される危険性が高まるとして、クリックやシェアは慎重に行うよう忠告。

個人を特定できる情報にアクセスできない設定を行ったり、個人情報がダークウェブに流出した場合に通知を受ける設定を行うなどして、サイバー犯罪者が自分のクローンを作成できないように個人情報の管理に努めるといった方法を紹介している。

マカフィー 日本・アジア地域チャネルマーケティング本部長の青木大知氏は、次のようにコメントを寄せている。

「AIは私たちのビジネスで素晴らしい機会をもたらしたり、生活を便利にしたりしますが、悪用されるリスクもはらんでいます。日本は他国に比べ、音声データのオンライン共有率が低く、結果的にAIを悪用した音声詐欺の遭遇率も低い傾向にありますが、この現状はむしろ、今後、音声詐欺に遭遇する可能性が高いとも受け取ることができます。McAfee Labsの調査で、AIボイスクローニングツールを利用して、わずか3秒で85%の一致率を有する音声クローンを作成できることが分かりました。このようなAIを悪用した音声クローニング詐欺が横行しやすい現状を認識し、自分のアイデンティティの共有に慎重になるとともに、音声詐欺の遭遇に備えた準備が必要です」

これは、同社が日本を含む世界7か国(日本、米国、英国、ドイツ、フランス、インド、オーストラリア)を対象に実施した、AIを悪用したオンライン音声詐欺の現状に関するレポート「The Artificial Imposter」に基づくもの。

上記7か国の18歳以上の成人7,054人を対象に調査を行ったところ、10%が自身がAI音声詐欺に遭遇、15%が知人が遭遇したとの回答があったという。さらに、被害者の77%が実際に金銭被害にあったと回答している。

なお、日本のオンライン音声詐欺の遭遇率は世界7か国で最も低くなっており、自身が遭遇は3%、知人が遭遇は5%と、世界平均の約3分の1に留まった。

人の声(声紋)は、いまや非常に高精度な個人認識が可能だが、調査対象となった世界の成人の過半数が週に1回以上、全体の10%は週に5回以上、自身の音声データをオンラインで共有している。この声がサイバー犯罪者に狙われて、コピー・悪用される格好の材料となっている。

同社の調べによれば、詐欺師はAI技術を使って声のクローンを作り、困窮を偽ったボイスメールを送ったり、被害者の連絡先に電話をかけていることが明らかになっている。また、クローン音声と本物の識別については、「識別できるかどうかわからない(35%)」または「識別できないと思う(35%)」として、およそ70%の回答者が自信がないと答えており、音声クローニングによる詐欺が勢いを増す要因にもなっているという。

さらに今回の調査では、ディープフェイクや偽情報が増加することで、オンラインで目にする情報に対してより警戒心が高まっているということも判明。成人の実に32%が、以前よりもソーシャルメディアに対する信頼度が下がったと回答した。

なお、日本の音声データのオンライン共有についてもまた世界7か国で最も低く、週1回以上の共有が28%、週に5回以上は5%で、世界平均の半分ほど。オンライン共有をあまり行わないことも、オンライン音声詐欺の遭遇率の低さにつながっているとも考えられる。とはいえ、“音声クローンが3秒で作成できる” という今、日本においても注意が必要と同社は呼びかける。

では、AIを悪用した音声クローニングの詐欺から身を守るにはどのような方法があるのかだが、マカフィーはまず、家族や信頼できる親しい友人との間でのみ通用する「パスワード(合言葉)」の共有を推奨。特に、高齢者や、家族、友人が電話や電子メールで助けを求めてくる際は「相手にパスワード(合言葉)を求めることを習慣づけるようにしましょう」とアドバイスしている。

また、根本的に発信者への疑念を抱くことも大切だとする。知らない発信者からの電話やテキスト、電子メールのみならず、見覚えのある番号からの発信であっても、送金など詐欺に類する行為を求めてくる場合には、「一呼吸置き、電話を切る、相手に直接電話をかけ直すか、情報を確認してから応答する」などを心掛けるように勧めている。

ほか、ソーシャルメディアネットワークに参加している場合、自分のアイデンティティを共有するほど自身のアイデンティティが悪意のある目的でクローン化される危険性が高まるとして、クリックやシェアは慎重に行うよう忠告。

個人を特定できる情報にアクセスできない設定を行ったり、個人情報がダークウェブに流出した場合に通知を受ける設定を行うなどして、サイバー犯罪者が自分のクローンを作成できないように個人情報の管理に努めるといった方法を紹介している。

マカフィー 日本・アジア地域チャネルマーケティング本部長の青木大知氏は、次のようにコメントを寄せている。

「AIは私たちのビジネスで素晴らしい機会をもたらしたり、生活を便利にしたりしますが、悪用されるリスクもはらんでいます。日本は他国に比べ、音声データのオンライン共有率が低く、結果的にAIを悪用した音声詐欺の遭遇率も低い傾向にありますが、この現状はむしろ、今後、音声詐欺に遭遇する可能性が高いとも受け取ることができます。McAfee Labsの調査で、AIボイスクローニングツールを利用して、わずか3秒で85%の一致率を有する音声クローンを作成できることが分かりました。このようなAIを悪用した音声クローニング詐欺が横行しやすい現状を認識し、自分のアイデンティティの共有に慎重になるとともに、音声詐欺の遭遇に備えた準備が必要です」